Wie funktioniert Suchmaschinenoptimierung?

Begriffsdefinition Suchmaschinenoptimierung (laut Wikipedia):

Suchmaschinenoptimierung, oder englisch search engine optimization (SEO), bezeichnet Maßnahmen, die dazu dienen, dass Webseiten im organischen Suchmaschinenranking in den unbezahlten Suchergebnissen (Natural Listings) auf höheren Plätzen erscheinen.

Was ist ein Backlink?

Begriffsdefinition Englisch (laut Wikipedia.org): A backlink for a given web resource is a link from some other website (the referrer) to that web resource (the referent). A web resource may be (for example) a website, web page, or web directory.

Begriffsdefinition Deutsch (laut Wikipedia.de): Ein Rückverweis oder Backlink bezeichnet einen eingehenden Link auf eine Webseite, der von einer anderen Webseite aus auf diese führt.

Der Backlink war die Keimzelle des Google Suchalgorithmus. Der wichtigste Parameter für die Einordnung einer Seite in den Google Suchergebnissen war immer der Backlink. Im Laufe der Jahre sind zahlreiche weitere Faktoren hinzu gekommen, die verstärkend oder abschwächend auf das Ergebnis des Google-Algorithmus wirken. Der Backlink ist aber immer noch dessen Herz.

Kurzer Blick in die Geschichte der Suchmaschinenoptimierung

Die ersten Versionen des Algorithmus wendeten bereits mathematische Verfahren an (z.B. Keyword-Dichte), um die Inhalte einer Seite zu bestimmen. Anschließend gewichtete der Algorithmus den inhaltlichen Wert der Seiten durch die Backlinks, d.h. die Verweise anderer Seiten auf die Inhalte. Daraus errechnete die Suchmaschine einen Stellenwert, der als Page Rank bezeichnet wurde. Dieser Page Rank war lange Zeit der wichtigste Faktor beim Ranking in den Suchergebnissen. Die Ergebnisse ohne bezahlte Ads bezeichnet man als natural oder organic Ranking. Ziel einer jeden SEO-Maßnahme ist die Verbesserung des Rangs in dieser organischen Suche. Links von Seiten mit hohem Page Rank – also einem höheren qualitativen Wert in der Wahrnehmung der Suchmaschine – hatten folgerichtig einen höheren Wert als Backlinks von Seiten mit niedrigem Page Rank. Die Suchmaschinen verwendeten demnach quantitative (Anzahl der Backlinks) und qualitative Faktoren (Page Rank der linkenden Seite) zur Einschätzung des Wertes einer Seite.

Webmaster fanden sehr bald heraus, dass ein hoher Rang in den organischen Suchergebnissen einen bedeutenden wirtschaftlichen Wert darstellt. Dementsprechend fanden sie Mittel und Wege, sowohl den Page Rank selbst als auch die entsprechenden Backlinks zu manipulieren. Dabei wird unterschieden zwischen sogenannten „White Hat“ Maßnahmen, die den Google Richtlinien für Webmaster entsprechen, und „Black Hat“ Methoden, die gegen diese Richtlinien verstoßen und dementsprechend im Verborgenen stattfinden müssen. Wenn Google Black-Hat-Maßnahmen entdeckt, wird die entsprechende Seite abgestraft – sie erhält einen Google Penalty. Die Strafe kann in einer Herabstufung um wenige oder gar hunderte von Rängen bestehen. Eine Seite kann für ein bestimmtes Keyword (und seine Synonyme) gesperrt werden. Oder die Seite kann komplett deindexiert werden, womit sie quasi unsichtbar und damit wertlos wird.

Backlinks und andere Ranking-Faktoren

Seit der wirtschaftliche Wert einer guten Platzierung in den SERPs (Search Engine Result Pages) erkannt wurde, entstand ein Katz-und-Maus-Spiel zwischen kreativen Suchmaschinenoptimierern und Google, dessen Ziel es ist, den Suchenden die besten Suchergebnisse zu präsentieren – und nicht etwa diejenigen, die am besten für seinen Suchalgorithmus optimiert wurden. Google versucht daher beständig, weitere Faktoren in seine Algorithmen einzubauen, die eine Manipulation erschweren, als zusätzliches vertrauensbildendes Signal gewertet werden können, verstärkend oder abschwächend auf andere Faktoren einwirken, und viele andere mehr. Da Google diese Faktoren und deren Gewichtung niemals preisgibt, können immer nur Mutmaßungen über die Gewichtung einzelner Parameter und deren Zusammenspiel angestellt werden. Es besteht aber Einigkeit darüber, dass es sich (Stand Q2 2016) um mehr als 200 Faktoren handelt. Google ändert seine Algorithmen aber auch mehrere hundert Mal pro Jahr. Zudem werden regional und periodisch unterschiedliche Formen des Algorithmus angewendet, und diese werden untereinander ausgetauscht. Aus diesen Gründen ist ein Re-Engineering der Algorithmen niemals vollständig möglich, und jede Darstellung der gegenwärtig wichtigsten Ranking-Faktoren beschreibt stets den letzten Stand des Irrtums. In diesem Falle ist Google den SEO-Experten immer eine Nasenlänge voraus.

Googles Anti-Spam Politik

Anders verhält es sich bei Googles Anti-Spam-Bemühungen. Google konnte eine Verfälschung der Suchergebnisse durch Ergebnismanipulationen nicht hinnehmen, da dies den Kern seiner Geschäftsgrundlage in Frage stellt. Mit der dem Unternehmen eigenen Professionalität ergriff Google Gegenmaßnahmen, die methodisch, langfristig und nachhaltig angelegt sind, und gründete dazu ein eigenes Anti-Spam-Team.

Dieses Team umfasst mittlerweile mehrere tausend Mitarbeiter, davon weit über tausend mit einem Doktortitel. Viele arbeiten an der Entwicklung von Algorithmen, die Suchergebnismanipulationen aufspüren sollen. Diese Algorithmen sind teilweise hochgradig komplex. Es laufen zahlreiche Suchroutinen ab, die alle auf einen „Spam Score“ einzahlen. Lange Zeit wähnten sich die professionellen Optimierer auch bei unerlaubten Maßnahmen in Sicherheit, da die schiere Rechenpower zur Überprüfung von Milliarden Webseiten und deren Backlinks (und den Backlinks zu den Backlinks – und so fort) utopisch erschien. Mittlerweile ist klar geworden, dass Google nicht nur über schier unglaubliches Rechnerpotenzial verfügt. Auch die Algorithmen arbeiten „ressourcenschonend“. Viele Algorithmen werden erst gestartet, wenn der Spam Score einer Seite einen bestimmten Grenzwert überschreitet. Dann können diese rechenintensiven Operationen selektiv auf eine Seite und deren Backlinkstruktur angewendet werden. Es müssen also keineswegs alle Algorithmen bei allen Webseiten angewendet werden.

Damit ist das Ausmaß von Googles Bemühungen nur gestreift. Wer glaubt, dass hier nur Mathematiker am Werk sind, darf sich eines Besseren belehren lassen. Google beschäftigt auch ein Team von promovierten Verhaltenspsychologen. Was diese zur Effektivität des Google Anti-Spam-Teams beitragen, beschreiben wir in einem weiteren Artikel.

Selbstverständlich werden auch ganz „traditionelle“ Spionagetechniken angewendet. Es ist bekannt, dass Google einige berüchtigte Black-Hat-Experten, die teilweise als Stars der SEO-Branche galten, angeheuert hat, teils offen, teils verdeckt. Darüberhinaus gehen alle hochrangigen SEO-Gruppen davon aus, dass sie von Google-Mitarbeitern bzw. Informanten unterwandert sind. Bei der Manipulation von Suchergebnissen ist das Verhältnis dennoch umgekehrt: Die SEO-Experten haben meist noch einen Vorsprung vor Googles Bemühungen zur Aufdeckung. Allerdings ist dieser Vorsprung in den letzten Jahren stetig kleiner geworden.

Googles Bestreben ist es, Webmaster dauerhaft und nachhaltig von Manipulationen abzubringen. Dazu muss Googles Anti-Spam-Team nicht zwangsläufig jede Manipulation finden und mit einem Penalty belegen. Letzten Endes wird das Unternehmen sein Ziel auch dann erreichen, wenn der Aufwand, der zur SERP-Manipulation und zur Risikominimierung betrieben werden muss, unvertretbar hoch wird, das heißt wenn er die potenziellen Erträge überwiegt. In diesem Fall würden betriebswirtschaftliche Überlegungen die Manipulationen unrentabel machen. Wir gehen davon aus, dass Google diesem Ziel ständig näher kommt. Aus diesem Grund werden in der Düsseldorfer SEO-Agentur TrafficManufaktur ausschließlich White Hat Praktiken angewendet.

Was muss ich mir unter Ranking Manipulation vorstellen?

Hier seien zwei Beispiele gegeben, die in den letzten 10 Jahren eine Rolle gespielt haben.

Automatic Link Building – ein quantitatives Verfahren

Diese Methode war noch vor ca. 10 Jahren der heilige Gral der Suchmaschinenoptimierung. Stark vereinfacht erklärt: Es handelt sich um softwarebasierte massenhafte Link-Generierung. Dabei verfügt die Software über ein umfangreiches Verzeichnis von Blogs, Foren, Verzeichnissen, Link Farmen (Seiten, die nur dem Zweck dienen, massenhaft Links zur Verfügung zu stellen) usw., die Einträge durch Dritte gestatten. Die Software übernimmt es dann, Einträge in all diesen Verzeichnissen zu erstellen. Der Anwender kann Einfluss auf die Auswahl der Verzeichnisse nehmen, und er kann selbstverständlich den Anchor Text bestimmen.

Der Anchor Text ist der Linktext, mit dem auf eine Seite verwiesen wird. Drei Beispiele, die alle auf die Phantasie-URL www.zahnarzt-kieferbruch.de verweisen (Hinweis: Die Links funktionieren nicht, da das Ziel nicht wirklich existiert):

1) Der beste Zahnarzt ist immer der, der den Bedürfnissen des Patienten gerecht wird. Mehr Informationen finden Sie hier: http://www.zahnarzt-kieferbruch.de.

2) Der beste Zahnarzt ist immer der, der den Bedürfnissen des Patienten gerecht wird. Mehr Informationen finden Sie hier.

3) Der beste Zahnarzt ist immer der, der den Bedürfnissen des Patienten gerecht wird.

Wenn Sie versuchen, für die Phrase „der beste Zahnarzt“ ein hohes Ranking zu erzielen, ist dazu nur der dritte Link wirklich geeignet. Das wissen die Suchmaschinenoptimierer, und das weiß Google. Wenn nun diese Phrase zu oft als Anchor Text auftaucht, geht der Google Algorithmus wiederum von einem Manipulationsversuch aus und straft die Seite ab.

Bei diesem Verfahren wurden die Grenzen des Link Building nur von der verfügbaren Rechenpower und vom Geldbeutel des Auftraggebers limitiert. Viele Seiten verfügten in kürzester Zeit über zigtausende Backlinks. Die Seiten schossen in den Suchresultaten nach oben. Es ist offenkundig, dass es sich bei diesen Methoden um einen flagranten Verstoß gegen Googles Webmaster-Richtlinien handelt. Sie mussten daher im Zentrum von Googles Antispam-Bemühungen stehen, und im Jahr 2012 ereilte sie ihr Schicksal in Form eines Pinguins. So hatte Google seinen entsprechenden Algorithmus benannt (Penguin). Im Mai 2013 ging Penguin in die zweite Runde. Johannes Beus stellte damals auf seinem Blog eine der ersten Auswertungen zur Verfügung:

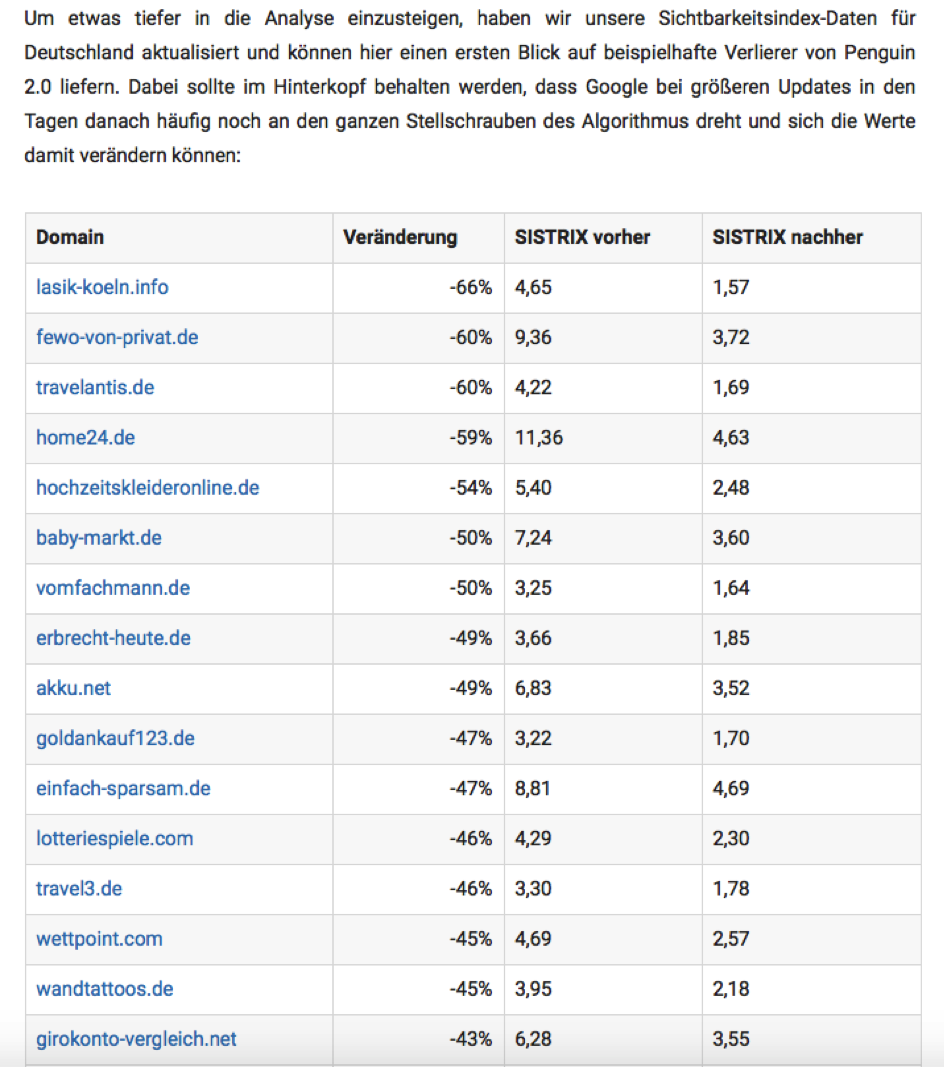

Auswirkungen von Suchmaschinenoptimierung, welche von Google als „Spam“ identifiziert wird. Sistrix GmbH, Johannes Beus: Erste Auswirkungen von Penguin 2.0, 23. Mai 2013 (Penguin 2.0: Erste Daten.).

Sowohl lokale Unternehmen wie lasik-koeln.info als auch bundesweit tätige Unternehmen wurden durch Penguin 2.0 bestraft. Es ist unschwer zu erkennen, wie stark diese Seiten durch den Penguin Algorithmus getroffen wurden. Nur wenige der Seiten konnten später durch aufwändige „Entgiftungsverfahren“ wieder profitabel gemacht werden. Genauere Informationen zu Google Penalties finden Sie auf anderen Seiten in unserem SEO-Bereich.

Das Verfahren, massenhaft Links zu generieren, wird übrigens auch heute noch angewendet. Allerdings werden dabei die Seiten, auf die mit massenhaften Backlinks verwiesen werden, so weit von der eigentlich zu optimierenden Seite entfernt, dass der aktuelle Google Algorithmus nicht greift. Dass dies nur eine Momentaufnahme ist, und dass eine derartige Vorgehensweise mit beträchtlichen Risiken verbunden ist, wissen Sie nun schon.

PBN – Personal Blog Networks – ein qualitatives Verfahren

Personal Blog Networks folgten auf die automatisierten Verfahren, die sich durch die Google-Algorithmenanpassungen absehbar überlebt hatten. Dabei macht man sich zunutze, dass Google den Links unterschiedliches Gewicht zumisst. Ein Link von einer Seite, die nach Googles Qualitätsmaßstäben Vertrauen und Wert besitzt, gilt ungleich mehr als ein Link von einer Seite, die als weniger vertrauenswürdig angesehen wird. Früher maß Google diese Qualität im sogenannten Page Rank (PR) auf einer Skala von 1 bis 10. Google selbst (und beispielsweise Wikipedia oder YouTube) hatten einen Page Rank von 10. Ein Link von einer Seite mit einem PR5 konnte eine Seite durchaus ohne Umwege auf Seite 1, je nach Suchbegriff sogar auf Platz 1 bei Google befördern. Die Konsequenz für die Search Engine Optimization war es, Links auf Seiten mit hohem Page Rank zu platzieren. Solange dies geschieht, indem man zum Beispiel einen Artikel schreibt und diesen auf der hochrangigen Seite platziert (unter Nennung des Autors), ist gegen diese Methode nichts einzuwenden.

Da dies aber in der Regel unmöglich oder zumindest sehr aufwendig ist, wenn man nicht Journalist ist, machten sich die SEO-Experten eine Eigenheit des Google-Algorithmus zunutze. Bei Seiten, die durch ihre Eigentümer nicht mehr weiter betrieben werden, bleibt das Google-Vertrauen, gleich ob als Page Rank oder auf einer anderen Skala, zunächst erhalten. Google muss so verfahren, denn es kommt oft vor, dass Betreiber einer Seite versehentlich die Registrierung auslaufen lassen. Die Seite wird dann stillgelegt, aber der Betreiber hat eine Karenzzeit, um die Seite neu zu registrieren. Oder der Betreiber konsolidiert Domains, und die Inhalte der alten Seite werden auf eine neue umgezogen. Würde Google sein Qualitätsranking sofort entziehen, sobald eine Seite den Eigentümer wechselt oder eine Weile nicht erreichbar ist, würden viele Webmaster große Schäden erleiden. Die Seite behält also noch eine Weile ihren Wert, insbesondere solange die Backlinks von anderen Seiten erhalten bleiben. SEO-Experten begannen, in großem Stil hochwertige Domains zu kaufen, deren Registrierung ausgelaufen war. Sie sorgten dann dafür, dass die vielen Backlinks auf die Seite nicht ins Leere liefen und erhielten auf diese Weise den qualitativen Status der Seite. Danach begannen sie, die Inhalte auszutauschen und Links auf diejenigen Seiten zu richten, die sie in den Rankings nach oben bringen wollten. Dieses Verfahren war sehr erfolgreich und löste eine regelrechte Goldgräberstimmung bei vielen SEO-Experten und Agenturen aus. Es war nun möglich, mit überschaubarem Aufwand in kürzester Zeit Seiten nach oben zu katapultieren. Für die Kunden wirkte dies nahezu wie Zauberei. Dieses Verfahren funktioniert prinzipiell auch heute noch.

Aber natürlich ist auch diese Vorgehensweise gänzlich unverträglich mit Googles Richtlinien. Allerdings sind Personal Blog Networks, wenn sie geschickt aufgebaut und mit ausreichend Camouflage versehen sind, von Algorithmen viel schwieriger zu entdecken als Massenlinks. Dementsprechend dauerte es etwas länger, bis Google in großem Maße „zurückschlagen“ konnte. Dies geschah mit dem sogenannten „Skyfall“-Update Ende 2014. Skyfall machte seinem Namen in den ersten Monaten alle Ehren. Zahlreiche PBNs wurden ausgehoben, und die Seiten sehr renommierter SEO-Agenturen, die bis dahin die Suche in ihrer Stadt oder Region dominiert hatten, waren plötzlich unsichtbar. Leider betraf dies aber auch die Seiten zahlreicher SEO-Kunden, deren Geschäft über Nacht zusammenbrach. Häufig bestand die einzige Rettung darin, wiederum eine SEO-Agentur anzuheuern, die sich mit „Detox“ auskannte. Das Entfernen toxischer Backlinks ist eine schwierige Arbeit, bei der jeder Schritt sorgfältig bedacht und pedantisch durchgeführt werden muss. Es gibt nur wenige Agenturen, die die Techniken korrekt beherrschen, und diese lassen sich die Dienstleistung natürlich entsprechend gut bezahlen.

Fazit: Wir haben hier zwei Verfahren zur Manipulation der Rankings in den organischen Suchergebnissen kurz skizziert. Beide Methoden sind „Black Hat“ und werden von Google mit Penalties belegt. Wir beschäftigen uns in der TrafficManufaktur deshalb ausschließlich mit White-Hat-Maßnahmen. Sie erfordern mehr Planung, sie sind aufwendiger, sie dauern länger. Und sie haben den Vorteil, das Geschäft unserer Kunden keinem unkalkulierbaren Risiko auszusetzen.

Besonderheiten der Suchmaschinenoptimierung in Deutschland

In Deutschland gibt es eine Besonderheit, die das Geschäft der Suchmaschinenoptimierung beeinflusst und ein weiteres Argument dafür liefert, auf sogenannte Black-Hat-Methoden zu verzichten. Dabei handelt es sich um das Telemediengesetz (TMG), das seit 1. März 2007 in Deutschland gilt. In dieser Gesetzesvorschrift wird geregelt, dass jede Internetseite ein Impressum aufweisen muss, in dem der Verantwortliche im Sinne des Presserechts namentlich und mit Kontaktdaten benannt wird. Dies gilt für alle Domains, die in Deutschland bei der Denic registriert werden (Domains mit der Endung .de), aber auch für alle anderen Seiten, die Inhalte in deutscher Sprache enthalten und die nicht zu rein privaten Zwecken dienen. Darüber hinaus ist für .de-Domains eine private Registrierung, also das Verbergen der Daten des Domaininhabers, nicht möglich. Beide Regelungen sind im anglo-amerikanischen Raum unbekannt, was den Aufbau und Betrieb eines Private Blog Networks sehr erleichtert.

Würde man in Deutschland ein PBN betreiben wollen, müsste man entweder gegen die Vorschriften des Telemediengesetzes verstoßen, oder man müsste an Google adressieren, welche Seiten man kontrolliert und somit den gesamten Daseinszweck des Netzwerkes entwerten. Außerdem kommt hier der persönliche Google-Penalty zum Tragen. Matt Cutts, der lange Zeit die Anti-Spam-Aktivitäten von Google leitete, hat schon vor vielen Jahren gewarnt, dass Google diejenigen Webmaster, die gegen die Richtlinien verstoßen, mit einem persönlichen Spam-Score markieren wird. Ein Webmaster würde sich in einem solchen Fall möglicherweise alle zukünftigen Chancen verbauen, Seiten weit oben in den SERPs zu platzieren, selbst wenn es sich um völlig andere Themen handelt.

Auch aus diesem Grunde eignen sich nur „genehmigungsfähige“ SEO-Praktiken. Dass Google gleichzeitig darauf hinarbeitet, dass die Werbeergebnisse oberhalb der organischen Suchergebnisse an Bedeutung und Sichtbarkeit gewinnen, ist eine weitere Herausforderung für die Suchmaschinenoptimierung. Es bleibt spannend.